Ricoh Theta en condiciones lumínicas complicadas

Llevamos al extremo la Ricoh Theta, tratando de capturar condiciones lumínicas complicadas. Para ello, nos aprovechamos del último firmware de la cámara y la última actualización de la app que controla la cámara de forma remota.

Te cuento mis impresiones, y te muestro los resultados obtenidos. Además, también podrás descargarte el material utilizado en el post para hacer tus propias pruebas.

Este es un post exclusivo para los usuarios de elephant vfx pro. Desde vuestra página de contenidos podéis acceder al artículo.

Cinco vaticinios en VFX para 2017

El otro día me topé con este artículo firmado por Ian Failes, quien seguramente sea uno de los pocos (muy pocos) escritores y periodistas con la suficiente preparación, conocimiento y sobre todo, contactos en la industria, para poder publicar sobre temas referentes a los efectos visuales con cierto rigor y objetividad, y a quien respeto por su dedicación, constancia y humildad. Desde hace algún tiempo, Ian ya no trabaja para Fxguide, ahora se gana la vida como freelance escribiendo para diferentes sitios especializados, y también acercándose a los mass media para contar historias referentes a la industria a la que nos dedicamos.

No he podido resistirme a comentar algunos de los puntos, que también son parte de conversaciones recurrentes entre colegas de profesión.

VFX Prediction #1: We’re headed for a big VFX Oscar upset (again)

El punto número 1 dice que parece que vamos directos a otra desilusión en los Oscars de Visual Effects, como ocurriese el año pasado con Ex Machina.

El escritor prevee una situación similar este año, donde Arrival es un serio candidato a ganar la estatuilla, enfrentándose a cintas con heavy visual effects como Star Wars, The Jungle Book o Doctor Strange. Si Arrival finalmente ganase el Oscar, sería según la predicción del artículo, motivo de enfado o decepción.

No podría estar en mayor desacuerdo con lo escrito por Ian. Del mismo modo que pensaba que Ex Machina debía ganar el año pasado, pienso que Arrival debería ganar este año. Para ser del todo sincero, no he visto Star Wars, y juzgo sus visual effects por lo visto en entregas anteriores y por el estilo de ILM. Lo único que le daría un plus añadido a Star Wars, es la creación del doble digital de Peter Cushing, que parece haber superado el mejor doble digital realizado hasta la fecha (Benjamin Button).

Otra película digna de mención es The Jungle Book, la cual considero tiene unos efectos visuales impecables en muchos planos, que por razones obvias (cantidad/presupuesto) no mantienen el nivel en toda la película, pero que por desgracia, como he comentado en anteriores ocasiones, este show es para mi, el claro ejemplo de la mala utilización de los visual effects. (podemos entrar en detalle sobre esto en otra ocasión).

Arrival, es por el contrario, el ejemplo perfecto (al igual que lo era Ex Machina) de visual effects concebidos y ejecutados de forma magistral, y que además, y más importante todavía, son lo que necesita la narrativa, y los VFX siempre han de estar al servicio de la historia, si no, las películas se transforman en demo reels de 90 min.

VFX Prediction #2: Digital characters will get their moment in the spotlight

El punto número 2 dice que en 2017 los personajes digitales cobrarán mucha importancia, especialmente en títulos como Spiderman, Planet of the Apes, Guardians of the Galaxy, etc. pero sobretodo, en lo referente a humanos digitales, como el ya mencionado, el difunto Peter Cushing de Star Wars.

En este caso, estoy de acuerdo. Hay menos disaster movies (o eso creéis) en favor de character driven movies, es un hecho. Lo que me gustaría mencionar en este punto, es una tendencia actual (a raíz de Star Wars especialmente) donde la prensa "común" (no especializada en VFX) habla de si es lícito, legal y/o moral crear actores digitales que están muertos. Escritores y periodistas del mundo, no se están recreando actores, se están recreando personajes, que es muy distinto.

A nadie (espero) se le ocurriría recrear a Carrie Fisher (desgraciadamente fallecida hace poco) o a Mark Hamill (cuando este pase a mejor vida) para interpretar el papel principal (o secundario) de una nueva película. Los actores principales de Star Wars (incluido el no mencionado) no son precisamente Danny-Day Lewis o Meryl Streep. No se revive a los actores (que poco interesan, al menos estos en particular) si no a Leia y Luke (que si interesan).

Otra cosa sería revivir personalidades, como si ha ocurrido, como por ejemplo con el rapero 2Pac o con otras celebridades como Bruce Lee o Audrey Hepburn. En estos casos, poco que decir. Para eso se han inventado los derechos de imagen, para seguir exprimiendo la gallina de los huevos de oro. Díganselo a James Dean o Elvis, por ejemplo. Aun así, estos experimentos han sido notoriamente fallidos, al menos de cara a vender, que era su único propósito de concepción.

VFX Prediction #3: De-ageing will remain all the rage

El punto 3 dice que rejuvenecer actores/actrices seguirá en alza.

Poco mas que añadir. Esto pasa y pasará más a menudo, ya que algunas empresas como Lola Post han demostrado que hay un mercado por explorar y pocos (de momento) capaces de hacerlo bien.

Si a esto sumamos que algunos actores/actrices exigen por contrato que su apariencia en las películas sea una determinada, no me extrañaría que retocadores profesionales del mundo del modelaje tradicional se involucrasen en los VFX facilities, para retocar a los actores en función de factores totalmente ajenos a la narrativa.

VFX Prediction #4: Practical effects are back in fashion

El punto 4 dice que los practical effects vuelven a estar de moda.

No se muy bien como interpretar esto, ya que los practical effects nunca han pasado de moda. Lo que se puede hacer mejor, o más rápido, o con más iteraciones o simplemente más barato, se seguirá realizando de forma digital, como viene siendo. Lo que por otra parte necesite realizarse en el set, de forma física, se hará, como también se viene haciendo. Por eso no entiendo muy bien este punto.

Quizás este enfocado desde el punto de vista de la prensa (no especializada) que lleva tiempo culpando a los efectos digitales de la paupérrima calidad de algunas películas. Como por ejemplo la nueva Jurassic Park. Obviamente, la culpa no es de los visual effects, que son considerablemente superiores a la original (como no podría ser de otra forma), si no de una pobre escritura, una malísima interpretación, una dirección (como siempre) condicionada por cientos de factores externos, y un único afán de rescatar uno de los blockbusters más exitosos. Supongo que por ahí van los tiros.

VFX Prediction #5: VFX houses become full studios

El punto 5 dice que los VFX facilities se convertirán en full studios.

Sin duda. Como ya sabemos, los VFX facilities no ganan dinero. En todos los (grandes) proyectos, en el mejor de los casos, no pierden pasta. Solo hace falta ver los números de los últimos años de los big facilities, pérdida y acumulación de de duda. Por eso los chinos, indios, y demás fortunas están comprando prácticamente todos los VFX facilities por menos dinero de lo que cuesta producir una sola de las películas en las que trabajan. En ocasiones anteriores ya hemos hablado del caso "Gravity" representando para mi, el pináculo de esta situación.

Una solución parece convertirse en full studios, no sólo en una empresa de servicios, y producir así sus propios shows, como los hacen los productores de cine de animación, que estos si ganan dinero. Así estamos viendo a grandes nombres de los VFX produciendo cine de animación, experiencias de realidad virtual, películas independientes, etc.

Gestión del color en efectos visuales

Conocer los aspectos técnicos detrás del color en efectos visuales es algo realmente complejo. La ciencia del color aplicada a la creación de imágenes sinteticas, es un tópico denso, complicado de entender (y explicar) y sin duda, yo no estoy capacitado para hacerlo de una forma correcta y precisa. Si realmente estás interesado en como funciona el color y como debemos utilizarlo en un pipeline complejo de VFX, te recomiendo que le eches un vistazo al paper publicado por VES, donde recoge en profundidad todos los tópicos que necesitas estudiar en relacion al color en el mundo audiovisual.

Lo que si voy a intentar explicarte de la forma más amena posible son los conceptos básicos y necesarios que considero cualquier VFX artist ha de comprender para poder desenvolverse con soltura en un pipeline de efectos visuales en cualquier estudio de VFX.

El color en efectos visuales parece ser un tema tabú, que mucha gente parece no comprender, otros ni siquiera están al corriente de como gestionamos el color en nuestros proyectos, y algunos, ni siquiera se interesan por el asunto. Tiempo atrás, algunos dejaron de trabajar en 8 bits y empezaron a trabajar de forma lineal. De esto hace años, y mucha gente hablaba de Linear Workflow, aunque la mayoría, se quedaron en como corregir los mapas de texturas para que su input fuese lineal y como renderizar imágenes flotantes de forma lineal sin hacer un bake de gamma.

Sin duda, es un paso, pero la mayoría de artistas siguen sin comprender los diferentes sistemas de color utilizados en VFX, incluso aquellos artistas trabajando en grandes VFX facilities. Muchos escuchamos términos como ACES o LUT, y realmente no sabemos que significan, o por qué debemos utilizarlos. Simplemente somos conscientes de que las imágenes mostradas en nuestro monitor de trabajo son diferentes cuando utilizamos un LUT u otro.

Por otro lado, profesionales trabajando en boutiques de VFX o estudiantes, nunca se han enfrentado a este tipo de terminología relacionada con el color, y cuando llegan a un estudio más grande, o simplemente han de colaborar en un proyecto global con varias boutiques, o realizan outsourcing para grandes estudios, etc. se topan directamente con algunos conceptos relacionados con el color que desconocen completamente.

Intentemos desde este blog arrojar un poco de información relacionada con este tema tan importante y necesario, siempre desde el punto de vista de quien escribe, un artista de efectos visuales, con las carencias que uno pueda tener en un campo tan complejo como la ciencia del color.

Asunciones generales

Como VFX artists vamos a tener que lidiar con diferentes tipos de material relacionados con color. Por simplificar el proceso digamos que tendremos que preocuparnos por recoger el material que viene de un set de rodaje, después tendremos que pensar en como almacenar ese material para poder utilizarlo a lo largo del pipeline de producción cinematográfica, después lo más importante será como poder visualizarlo correctamente, como trabajarlo en un entorno de VFX y finalmente, como distribuirlo para que pueda ser utilizado de forma correcta en las fases posteriores a la realización de los efectos visuales.

En set de rodaje, lo más importante relacionado con color son las fuentes lumínicas artificiales y las cámaras. Temperatura de color y tintado son las propiedades más importantes de las que debemos estar al tanto. Siempre necesitaremos Macbeth Charts y otros color samples para poder trabajar el color grading de forma correcta. La resolución y profundidad de color del material rodado también cobra importancia cuando trabajamos con color. LED, tungsteno, Kinoflo, etc. cada fuente lumínica tiene propiedades diferentes que tenemos que conocer para poder trabajar con los diferentes recursos de forma correcta, eficaz y sobre todo, consistentemente.

- Todos los estudios de VFX son diferentes.

Todos los estudios de VFX para los que he trabajado y con los que he trabajado, abordan la gestión de color de forma diferente, lo que me hace pensar que nadie trabaja de la misma forma. Es lógico, cada estudio (especialmente los grandes) utilizan un montón de herramientas propias que requieren ser tratadas de forma extraordinaria.

Como bien sabéis, no hay un solo proyecto que se realice de forma íntegra en un solo estudio de VFX, así que siempre toca lidiar con pipelines de color de otros estudios, ya que se comparten assets y otros materiales entre varios facilities.

- 8 bits

En el pasado solíamos trabajar en sistemas de color de 8 bits. Sin entrar en mucho detalle, digamos que solíamos bakear un gamma en la imagen de salida, esto permitía que las imágenes producidas se pudiesen representar bien en los dispositivos utilizados, tv, cine, monitor, etc. Podemos referirnos a este sistema de trabajo como sRGB pipeline.

No creo que quede un solo estudio sobre la faz de la tierra trabajando en 8 bits. Todos ya trabajamos de forma linear. Supongo que tu también.

- Physical Based Workflow

Hoy en día, prácticamente todos los estudios tienden a trabajar en un physical based workflow, donde todo el material se interpreta de forma linear. Footage, texturas, luces, shaders, renders, composición, etc. todo es o se convierte a linear para que los cálculos sean correctos. Nos referimos también a este sistema de trabajo como High Dynamic Range Pipeline o simplemente Linear Pipeline.

Cuando trabajamos en un Physical Based Workflow entendemos que utilizamos Plausible Lighting, Physical Based Shading y Physical Based Lighting and Rendering.

- Luts

Luts o Look Up Table, son por resumirlo mucho, archivos digitales que simulan la emulsión de una película fotográfica existente o inventada. Es decir, cuando aplicamos un LUT a un footage o a un render, éste va a cambiar en función del LUT aplicado. Los LUTs cambian en función del show y generalmente son elegidos por el cinematógrafo antes de rodar el proyecto. La productora se encargara de proporcionar el LUT utilizado a los diferentes departamentos que figuran en la producción cinematográfica, como VFX, editing, o DI.

En efectos visuales es extremadamente importante trabajar siempre con el LUT del show aplicado, ya que el resultado tras aplicar el LUT en ocasiones es extremadamente diferente. Es por esto que por ejemplo aplicaciones como Photoshop han quedado prácticamente desterradas de los pipelines de VFX, ya que no tienen soporte para LUTs y otros sistemas de color de los que hablaremos más adelante.

- Gamut

El gamut es el rango de color disponible en una imagen. Este rango de color puede variar de forma considerable en función del espacio de color utilizado. A continuación hablaremos de diferentes espacios de color.

Múltiple información, múltiples software

Independientemente de cual sea nuestro pipeline de VFX vamos a necesitar utilizar una cantidad de software ingente y tendremos que utilizar y generar todo tipo de información visual.

Partiremos seguramente de scans o footage de alta resolución (4k o 6k) en diferentes formatos y espacios de color, pero siempre con un rango dinámico muy alto. Muchas veces estos scans no son puramente digitales, aún se ruedan muchísimas películas en film, así que los scans puede que sean negativos escaneados.

También tendremos que trabajar con footage en 8 bits, con imágenes, HDR, con imágenes LDR, con texturas de todo tipo, etc.

Cuando hablamos de software, utilizaremos software comercial como Maya, Nuke, Mari, Arnold, Vray, RenderMan, Clarisse, Katana, Houdini, etc. Cada uno de estos paquetes son perfectamente capaces de gestionar color para VFX de diferentes formas. Además de todos los mencionados anteriormente, la mayoría de estudios de efectos visuales utilizan software propietario para cubrir sus necesidades más especificas.

En resumen, hay un montón de variables relacionadas con el color en nuestro pipeline, y si no las conocemos y si no somos consistentes a la hora de trabajar con color, seremos incapaces de realizar nuestra labor como VFX artists.

Output

Los efectos visuales no son el final del proceso cinematográfico, como muchos pueden pensar. Tras terminar los VFX de cualquier película, el material generado por el estudio al igual que el resto del footage rodado, pasan a la sala de DI (Digital Intermediate) donde el color va a sufrir importantes modificaciones artísticas en base a las opiniones subjetivas del director, el cinematógrafo y el colorista.

Si el material proporcionado por el estudio de VFX no tiene la suficiente calidad e información de color, cuando este sea manipulado en la sala de DI, empezaran a aparecer todo tipo de artefactos, banding, etc. así que tenemos que asegurarnos de que el material que generemos como VFX artists cumpla con los requisitos necesarios.

Ciencia del color

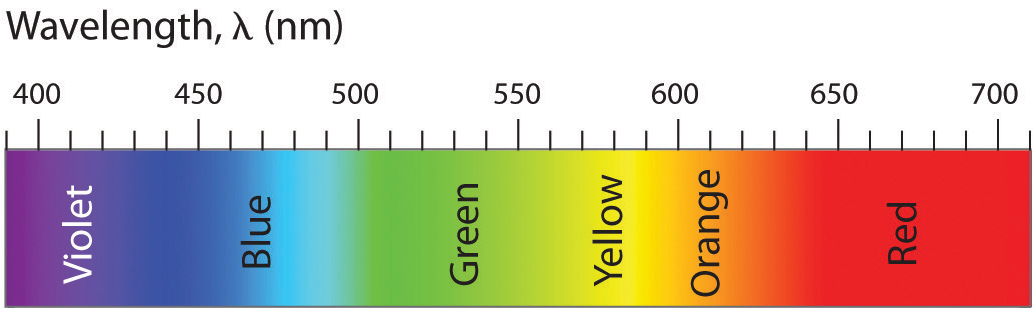

La energía de la luz puede medirse con la siguiente gráfica de longitud de onda o wavelength cuyas unidades son nm.

El espectro visible que el ojo humano es capaz de apreciar oscila entre 380nm y 780nm.

El sistema de vision humano es tricromático y ha sido mapeado al sistema de color CIE 1931 para que podamos medir colores físicos puros (wavelenght) en señales electromagnéticas correspondientes al espectro visible humano.

En las imágenes más abajo, tenemos representado el espectro en su totalidad. El triángulo mas grande corresponde al espectro visible humano, prueba de que no somos capaces en entender visualmente toda la información existente en la naturaleza.

El triángulo mediano, corresponde al gamut representado en el espacio de color REC 709 o también llamado HDTV

En las dos imágenes de abajo, podemos ver a la izquierda el gamut en el espacio de color sRGB y a la derecha, en el espacio de color CIE RGB. Lo que esto pone de manifiesto es que en función del espacio de color que utilicemos, vamos a ser capaces de revelar de forma directa más o menos información, con los pros y contras que ello conlleva.

RGB es un sistema de codificación de color que utiliza colores primarios (rojo, verde y azul) para crear un gamut específico. Recuerda que el gamut es el rango de colores, y que como hemos visto, varía en función del espacio de color utilizado. Este look basado en coloes primarios está obligadamente ligado al dispositivo donde se muestran las imágenes, nunca se ven de forma linear, siempre necesitan de un espacio de color pasa ser representados de forma correcta.

Display (sRGB) vs Scene (Linear)

Los espacios de color diseñados en relación con el dispositivo donde se van a representar imágenes, son llamados Display Referred, y varían como decimos, en función del dispositivo. Monitor, iPad, proyector, etc.

- En cuanto a colorimetría se refiere, se define en función de lo mostrado en pantalla.

- El rango dinámico es el que se ve en pantalla, no hay más.

- sRGB se utiliza como espacio de color en dispositivos RGB (gamma 2.2).

- Requiere de linearización (gamma inversa).

Los espacios de color diseñados para dispositivos de entrada son llamados Scene Referred.

- Los valores no son definidos en base a imagen en pantalla si no en base a unidades globales del mundo real.

- Se trabaja de forma linear.

- No hay valores máximos, por eso imágenes HDRI tienen valores extremadamente altos.

- Nos referimos a sus valores mediante stops, no mediante valores numéricos de pixels. No hablamos de contraste en términos de 1000:1 si no en términos de rango dinámico. A fin de cuentas, este es el lenguaje cinematográfico y cuando un cinematógrafo dice "aumenta 1 stop" se refiere a que dobles la iluminación de la escena.

- Para poder visualizar correctamente Scene Referred material, necesitamos aplicar un tone mapping a las imágenes, ya que si no, se verían demasiado oscuras. La mayoría de monitores no son capaces de visualizar imágenes lineares, por eso tenemos que aplicar tone mapping para poder visualizar imágenes HDR en monitores LDR.

- Un mínimo de 16 bits es necesario para trabajar con este tipo de imágenes.

Log

En ocasiones puede que nos encontremos con ficheros Log de 10 bits. En su día fueron el sistema estándar a través de Cineon y DPX aunque han sido prácticamente sustituidos por Floating Point .EXR

Generalmente cuando vemos este tipo de imágenes en un monitor RGB aparecerán completamente lavadas, es necesario visualizarlas con una codificación apropiada.

ACES y OPENCOLOR IO

Academy Color Encoding Space es un "nuevo" sistema de gestión de color que muchos estudios de VFX ya utilizan, guarda toda la información en Open EXR.

El espacio de color es High Dynamic Range o Scene Referred Linear Space, lo que quiere decir que el gris medio sera de 0.18 y no de 0.5

En la imagen de abajo se puede ver que el gamut o rango de color, es tan grande como el propio espectro visible.

OPENCOLOR IO es otro pipeline de color open-source adoptado por varios estudios de VFX cuyas mayores ventajas son la unificación de transformaciones y visionados de color entre múltiples plataformas y aplicaciones, lo que asegura una mayor estandarización.

¿Y en mi casa qué?

En tu casa has de trabajar siempre de forma linear. Si no partes de material linear tendrás que convertirlo.

Las operaciones en el motor de render siempre ocurren de forma linear, y tanto los inputs como los outputs han de ser lineares.

Si por ejemplo estás pintando texturas en Mari, hazlo en 16 bits (o 32 si es necesario) y expórtalas en formato .EXR

Si por el contrario, partes de fotografías descargadas de internet, estas serán de 8 bits .jpg por ejemplo. Así que deberás de linearizarlas antes de poder renderizarlas. Basta con añadir una función gamma 2.2 inversa. El siguiente gráfico muestra a la perfección como han de ser los inputs y los outputs.

Siempre vas a renderizar de forma linear y para poder visualizar tus renders de forma correcta simplemente has de utilizar el espacio de color apropiado para tu dispositivo. Generalmente sRGB.

En el caso de utilizar un LUT concreto, simplemente selecciónalo en Maya, en Nuke, en Mari o en el software que utilices. Lee la docuemntación de tu motor de render favorito para entender como interpreta la gestión de color.

Nueva gestión de color en Maya 2016

Cada software es único y la gestión del color se hace diferente dependiendo del producto y la versión. Vamos a ilustrar como funciona en Maya 2016, por aquello de ser el software standard en la industria y además, incorporar un nuevo sistema de gestión de color en esta nueva versión 2016.

- En las preferencias, asegúrate de tener activado Enable Color Managment.

- En el apartado Color Transformation, has de tener como Rendering Space linear sRGB, también podrías utilizar otros espacio de color si fuese necesario, como ACES, REC, CIE, etc. Seguramente en tu casa sólo vayas a utilizar linear sRGB.

- En la opción View Transform, utilizarás sRGB ya que vas a visionar tus imágenes en un monitor LDR. Podrías utilizar RAW en el caso de utilizar un monitor HDR o LOG por ejemplo. Pero generalmente en casa, no vas a utilizarlos.

- Existe la opción utilizar un pipeline OCIO y una ruta para seleccionar el archivo proporcionado para la producción.

- También existe la opción de indicar el espacio de color por defecto de tus imágenes. Puedes seleccionar sRGB o Linear. Por supuesto depende de tu pipeline de texturizado, generalmente en un VFX facility será Linear.

- En el apartado Output, existe la opción de hacer un bake de gamma al render final. Nunca vamos a utilizar esto.

- Un poco más abajo existe la opción de utilizar un fichero LUT, cuando sea necesario este será el lugar de colocarlo.

- El último setting que podemos necesitar es el llamado Show Color Managed Pots, para corregir por ejemplo, color swatches en los shaders.

- En este ejemplo, tengo dos MacBeth Charts completamente idénticas, la de la izquierda es una imagen de 8 bits en espacio de color sRGB .jpg. La imagen de la derecha es una imagen linear float point 16 bits .exr. Como puedes comprobar se visualiza de forma incorrecta en el visor de imágenes de OSX, porque éste no tiene forma de transformar el espacio de representación, como haría por ejemplo Nuke.

- Si queremos aplicar estas dos texturas en un pipeline de color linear, la imagen de la derecha funcionaría perfectamente, la imagen de la izquierda necesita ser linearizada.

- Para ello puedes añadir un inverse gamma de 2.2 (0.455) o cambiar el color space en el attribute editor a sRGB. En el caso de utilizar una imagen linear .exr deberíamos utilizar la opción RAW. Si utilizamos un pipeline linear, no necesitaríamos cambiar el color space de las imágenes lineares, ya que por defecto, hemos indicado en las opciones de Maya que estamos trabajando de forma linear.

Espero que haya quedado un poco más claro como gestionamos en color en proyectos de efectos visuales.

Fotos del workshop en Fictiza

Aquí tenéis algunas fotos del VFX Lighting Workshop que impartí en Ficticia.

Pásate por el Facebook de Fictizia para conocer más sobre el evento y sobre la escuela.

VFX Lighting en Fictizia

El fin de semana del 16 y 17 de Mayo estuve con los amigos de La Escuela Fictizia charlando sobre VFX Lighting en Madrid. Todo un gustazo, a ver si repetimos pronto! Gracias a todos!

Aquí algunos de los tweets del evento.

Gestión de información "on-set"

Este post está escrito únicamente desde el punto de vista de una persona que trabaja on-set realizando tareas de "VFX image acquisition" o recopilando información para proyectos de VFX.

Generalmente, en un proyecto de VFX de gran envergadura, como puede ser un "Hollywood blockbuster" se puede llegar a capturar alrededor 200Gb al día de información, solo referente a VFX. Por supuesto todo depende de la magnitud del proyecto, de la cantidad de VFX que se necesiten, de la complejidad de los mismos, etc.

El tipo de información que necesitamos entregar a un estudio de VFX también varía en función de las características del proyecto y en base a como trabaja el estudio en cuestión. Pero en lineas generales, siempre vamos a necesitar miles de fotografías RAW que servirán como referencia para modelado, texturizado, look-dev y lighting. Horas de grabación de "witness cam" que servirán como referencia para animadores, editores, FX artists, etc. Y un buen puñado de HDRIs con sus referencias oportunas para look-dev y lighting.

En definitiva, muchísima información que necesitamos gestionar de forma adecuada. Esto implica organizarse muy bien, de forma inteligente y sobretodo, tratar el material con total seguridad. Comentemos a continuación algunas buenas prácticas a la hora de enfrentarse a un trabajo on-set para un proyecto de VFX de importantes dimensiones.

Discos duros

La cantidad de discos duros que vas a necesitar depende de la duración del shoot. Por supuesto, esto varía en función del proyecto, pero para una película con una carga importante de VFX, estaríamos hablando de entre 15-20 semanas. Para ese tipo de rodaje no deberías llevar menos de unos 5 - 8Tb.

No es recomendable utilizar discos de más de 1Tb, Lacie Rugged de 500Gb o 1Tb son mis favoritos.

El procedimiento habitual para tratar este material tan sensible, es hacer backups constantemente. Ten en cuenta que puedes hacer fotos a un set y que al día siguiente lo hayan desmontado o destruido, así que perder información simplemente, no se contempla.

Haz un backup de un disco en otro disco. Quédate con uno y envía el otro al estudio de VFX via mensajería rápida y segura. Una vez confirmado que el estudio de VFX ha descargado todo correctamente, pide que te den luz verde para borrar tu backup (en caso que necesites almacenamiento extra, si no, no) y pide también que te envíen de vuelta el disco duro.

En el hotel

El trabajo on-set dura unas 10-14 horas diarias. Cuando terminas allí, aún te toca descargar todo el material recopilado a lo largo del día. Esta tarea puede ser larga y tediosa, así que asegúrate de que tus discos son rápidos. Thunderbolt, Firewire o USB3.0 como mínimo. Lo mismo con tus memory cards, cuanto más rápidas mejor. Procura utilizar lectores de tarjetas para agilizar el proceso. A mi me gusta el Lexar® Professional USB 3.0 Dual-Slot Reader.

Una vez todo ha sido descargado, haz al menos dos backups. Cuando los dos discos espejo estén llenos, envía uno al estudio de VFX y quédate con el otro. Cuando hayas terminado los backups, formatea todas las memory cards, carga todas las baterías y limpia todas las lentes, para que al día siguiente, todo este listo a primera hora.

Algunos hoteles ofrecen conexión a Internet profesional, con una ancho de banda de subida muy grande. Si es el caso, quizá prefieras hacer backups en el FTP o Cloud System de tu estudio. En otras ocasiones, en función del rodaje, puede que el hotel sea una caravana o una tienda de campaña.

A dormir.

Automatiza tareas

Generalmente la naturaleza de las actividades que realizamos on-set tiende a ser repetitiva. Es decir, siempre necesitamos referencias para modelado, referencias para texturizado, HDRIs, witness cams, etc. Si hay algún paso del proceso que crees que puede automatizarse, documéntalo e impleméntalo. Si tu, como yo, no estás técnicamente capacitado para hacerlo, pide ayuda o contrata a alguien que automatice tareas por ti mediante scripts, etc.

Yo tiendo a una vez formateados mis discos, generar una estructura de directorios de forma automática, como por ejemplo.

volume/asset/character

volume/asset/prop

volume/asset/environemnt

volume/sequence_###/shot_###_###

.../.../.../hdri/pano/plates/references

.../.../.../lidar

.../.../.../photogrammetry

.../.../.../modelling_reference

.../.../.../texturing_reference

.../.../.../witness