Arnold subdivision scripts

En el post anterior publiqué mi solución para añadir Arnold subdivision a varios objetos a la vez. Como de costumbre, mis soluciones en lo relacionado a automatismos son bastante rudimentarias y poco eficaces debido a mi inexistente conocimiento de scripting, programación, etc.

Como siempre, lo más sabio que uno puede hacer cuando no tiene mucha idea de algo es pedir ayuda. Así pues, mi amigo Ramón López me ha facilitado unos scripts programados por Pilar Molina que permiten realizar esta tarea mediante un simple click.

Por un lado hay un script que añade Arnold subdivision a todos los objetos de la escena. Otro script que hace lo mismo pero sólo con los objetos seleccionados. Y finalmente otro script que sustituye las texturas de tu escena por sus equivalentes en formato .tx

Todos múy utiles. Los scripts fueron desarrollados durante la producción del corto Shift.

Podéis descargarlos aquí o en la página de Github de Pilar.

Gracias a Ramón y a Pilar!

Photogrammetry asset gratuito

Con la reciente salida de nuestro curso "Photogrammetry 101" hemos decidido publicar uno de los assets que se quedaron fuera de los ejercicios del curso. Aún así, ya que teníamos las fotografías procesadas y el asset listo para trabajarlo, que mejor que compartirlo con nuestros lectores para que puedan hacerse una idea de los modelos y texturas que pueden producir utilizando las técnicas mostradas durante las más de 16 horas del curso.

Y para los alumnos que habéis tomado el curso "Photogrammetry 101" os invitamos a realizar este ejercicio utilizando las fotos proporcionadas y las técnicas que habéis aprendido a lo largo del curso.

En el fichero zip (1.5GB) podéis encontrar:

- Fotografías originales de alta resolución

- Archivo de Photoscan

- Modelo y texturas RAW

A ver quien se anima a realizar la retopology del modelo y limpiar las texturas para dejar un asset listo para producción VFX.

Pd: Si alguien se anima a realizar la retopology, yo hago las texturas en condiciones :)

Podéis descargar los archivos aquí.

Sistemas de partículas desde Maya a Clarisse

Ya hemos hablado en ocasiones anteriores sobre Isotropix Clarisse, si buscas por el tag "Clarisse", podrás ver todas las entradas al respecto.

En esta ocasión vamos a hablar de una tarea muy común cuando trabajamos con este software, que consiste en renderizar sistemas de partículas simuladas en otro software, en este caso Maya.

Como sabéis, Clarisse es un raytracer moderno que funciona de forma muy particular, una especia de scene assembler donde importamos todo el contenido realizado en un software 3D, y una vez en Clarisse nos beneficiamos de su tecnología para renderizar todos nuestros componentes 3D. Clarisse está siendo bastamente utilizado por estudios de efectos visuales digitales de la talla de Double Negative, ILM, Tippett Studio, etc. Iremos posteando más tutoriales, artículos y cursos en un futuro cercano.

En esta ocasión, vamos a ver como importar un sistema de partículas simulado en Maya para poder renderizarlo de forma muy rápida en Clarisse. Es un ejemplo extremadamente sencillo, pero espero ilustre la metodología de trabajo entre estos dos software.

- Una vez tenemos el sistema de partículas terminado en Maya, basta con exportarlo via Alembic, el formato estándard para intercambio de archivos 3D en VFX.

- Antes de continuar, es buena idea crear algún tipo de iluminación para poder ir viendo el restultado de nuestra escena 3D. En esta ocasión he creado un simple rig Image Baseg Lighting. En un post anterior explico como hacerlo de forma muy sencilla.

- En la versión 2.0 de Clarisse existe una herramienta en el self lighting que permite crear un rig IBL con un solo click.

- Para importar el archivo Alembic tenemos que ir a File -> Import -> Scene y seleccionar el archivo exportado previamente desde Maya.

- Este archivo debería importarnos dos sistemas de partículas, un plano que sirve como suelo y la cámara para renderizar la escena.

- Es buena idea crear diferentes context para mantener la escena organizada a medida que gana en complejidad.

- En el context geo, he importado dos ficheros .obj uno llamado toy_man y otro toy_truck. Estas son las geometrías que voy a utilizar en mis dos sistemas de partículas.

- También he movido el suelo a este context para tenerlo todo bien organizado.

- Del mismo modo he movido los sistemas de partículas y la cámara a sus correspondientes context.

- En el context materials, he creado dos standard shaders y dos file textures. Uno para cada geometría.

- En el context particles, he creado un nuevo sistema scatterer y lo he renombrado a scatterer_typeA.

- En el apartado geometry support del scatterer he añadido el sistema de particulas particles_typeA. Y en la sección geometry he añadido toy_man.obj

- También estoy añadiendo algo de variación en la rotación de las partículas.

- Si movemos el timeline podremos ver la animación de las partículas.

- No olvides asignar los materiales creados anteriormente.

- Para el segundo sistema de partículas, vamos a crear otro scatterer. Al igual que con el primer scatterer necesitamos indicar el geometry support y el geometry a utilizar, en este caso en toy_truck.obj

- También estoy introduciendo variación en la rotación y posición.

- Ya que estos modelos son bastante más grandes que los muñequitos, voy a introducir un offset en el sistema de partículas para que tengan menor presencia en pantalla.

- Finalmente, vamos a añadir motion blur a la escena para lanzar el render final.

- Vete a raytracer -> Motion Blur -> 3D Motion Blur.

- En esta ocasión estoy renderizando sólamente 40 millones de polígonos y como podrás comprobar, los tiempos de render son fantásticos.

Perdona, pero ya te has tomado un café hoy...

Calle en Eksjö, ,Jönköping, Suecia.

... O como elegir el sitio donde quieres trabajar.

Se que suena raro, no te preocupes, ahora mismo te explico el título de este post.

Como de costumbre, aprovecho ratos muertos en aeropuertos para escribir algunas cosas, y hoy, he recordado una conversación que tuve no hace mucho tiempo con un par de amigos y ex-compañeros de trabajo.

Trato de llegar a Eksjö, al sur de Suecia, donde voy a estar tres días hablando de texturizado y look-development en Jönköping University - Campus i12. Dos metros en Londres, un avión a Copenhague, un tren internacional a Suecia y otro tren local en el mencionado país, deberían de ser suficiente para llegar a la pequeña ciudad de casas de madera, pero como te puedes imaginar, el viaje será largo. Un par de libros y un iPad deberían ser buenos compañeros de viaje. Mierda, me he olvidado en la mesa del trabajo mis cascos noise cancelling y mis gafas de lejos. Tremendo error, ambos son vitales para mi cuando tengo que viajar. Empezamoms bien.

En la mecionada conversación con mis amigos y ex-compañeros de trabajo, hablamos entre otras cosas de un estudio en el que los tres trabajamos hace unos años, y ninguno de nosotros guardamos un buen recuerdo de aquella época, más bien todo lo contrario. Aquel era uno de esos lugares donde lo único que puedes aprender durantes largos meses trabajando allí, es que no quieres volver a trabajar en un sitio así. Tampoco creo que haya muchos sitios como ese, espero que no.

Pocos días después de aquella conversación, en un evento con estudiantes me preguntaron cuales eran mis preferencias a la hora de elegir la empresa en la que trabajar, o el proyecto al que unirme, etc. Querían saber por qué estaba en un determinado estudio y no en otro, o por qué me iba a tal sitio en lugar de quedarme en el estudio donde había estado hasta entonces.

Me tomé unos segundos para pensar la respuesta, pero de repente, vino a mi cabeza aquella conversación con mis amigos, y la respuesta salió por si sola. Déjame que la reproduzca aquí en una cuantas líneas.

Si trabajas muy duro, pones pasión en lo que haces, continuas tu formación, tienes un poco de talento y un mucho de suerte, tras varios años de trabajo en la industria cinematográfica, tendrás una buena demo reel, unas buenas condiciones contractuales, y unas cuantas recomendaciones de algún que otro VFX Supervisor. Lo que supone que en menor o mayor medida, vas a poder elegir el sitio donde trabajar.

La pregunta de los alumnos iba un poco por ahí. Si puedes trabajar en prácticamente cualquier estudio del mundo, que hace que elijas uno u otro.

La respuesta es puramente subjetiva, y cada individuo puede tener unas razones completamente diferentes a las mias. En mi caso, podría darte unas cuantas razones y motivos por los que he decidio trabajar para un estudio como Double Negative y no para otra empresa.

Quizás sea más fácil de entender mis motivos si reducimos las variables. Me explico, cuando somos más jóvenes, estudiantes, fans apasionados por el trabajo de otros, etc, los motivos más comunes por los que elegimos destino laboral son generalmente el tipo de proyecto. Por ejemplo, si eres un fan de Star Wars, querrás trabajar en ILM. Si eres un fan de El Señor de los Anillos, querrás trabajar en Weta, o si eres un fan de la animación cartoon, querrás trabajar en Pixar o Disney. En mi caso particular, este motivo concreto nunca ha existido. No soy muy fan del cine fantástico, o de la ciencia ficción, o de los super héroes, así que los proyectos en si nunca han sido un motivo para mi a la hora de elegir destino. Por ello, tampoco lo han sido los estudios, no me excita más una empresa de tres letras que de cuatro.

Después de unos quince años de experiencia laboral y unas veinte producciones cinematográficas, ya me he dado cuenta de dos cosas. Una, todos los estudios de VFX o al menos los big facilities, son prácticamente iguales. Existen pocas diferencias entre ellos, y cada vez menos. Son los pequeños detalles los que marcan la diferencia.

Y dos, en esta industria raramente trabajamos en buenas películas. Bien, no importa, yo hago efectos visuales, no escribo guiones, no desarrollo pesonajes, no cuento historias (o si, vete tu a saber). Mi parte del trabajo dentro de estas películas, se reduce al apartado visual, y en general, si es excitante y de buena calidad.

Quitando esas dos variables, nombre de estudio y tipo de proyecto, mis razones para elegir donde trabajar pueden ser quizás diferentes a las tuyas.

Localización geográfica

Para mi es muy importante en que ciudad y país se encuentra el estudio. Y por supuesto esta es una decisión muy personal, que varía muchísimo con el paso del tiempo. Si eres joven y no tienes muchas responsabilidades, esta industria es maravillosa. Podrás viajar alrededor del mundo trabajando en excitantes proyectos, conociendo culturas y haciendo amigos en varios continentes.

Si no eres tan joven, y dependes de alguien o alguien depende de ti, tendrás que buscar un sitio que se adapte a tus necesidades. En mi caso, una gran ciudad, europea a poder ser, y en la que se pueda hablar inglés sin mayor problema. También es muy importante que sea una ciudad con alternativas laborales, es decir, que cuando termine un proyecto, pueda encontrar otro en la misma ciudad y un espacio de tiempo reducido.

Londres, Amsterdam, Estocolmo, Munich, Berlín, etc, son solo algunas ideas.

Tras años viajando sin parar, trabajando unos meses aquí y unos meses allá, yo elegí Londres en busca de una estabilidad laboral que no alcanzaba a imaginar en otra ciudad. Como objetivo a largo plazo, quizás unos años seguidos trabajando en el mismo estudio, y ya puestos a imaginar cosas imposibles, un contrato permanente. Dice la leyenda que existen ese tipo de contratos en la industria del cine. (Como si sirviesen para algo).

Horario flexible

Creeme, no hay ni una sola persona en el mundo que sepa gestionar mi tiempo mejor que yo mismo. Yo necesito trabajar para un estudio que entienda que el trabajo, la productividad, no ocurre exclusivamente delante de una pantalla de ordenador, y mucho menos, no ocurre dentro de unos límites temporales establecidos, ni dentro de un espacio físico concreto.

Todos tenemos una agenda que cumplir, fechas de entrega, reuniones, dailies, client calls, etc. Sabiendo esto y cumpliéndolo a raja tabla, yo necesito un estudio que me permita autogestionar mi tiempo. Ya comenté en otro post que a mi me gusta madrugar, y en lugar de llegar a la oficina a las 09:00 prefiero llegar a las 07:00 por supuesto, también me gusta irme a las 17:00 en lugar de a las 19:00

Si cumpliendo con todas mis obligaciones, el estudio para el que trabajo no entiende esto, no me interesa mucho trabajar para ellos. Y aquí es cuando vas a entender el título del post.

¿Recuerdas aquel estudio para el que trabajamos mis dos amigos y yo? Bien, un día uno de mis amigos llegaba a la oficina tras tomarse un café, y uno de los responsables de producción se acercó ami amigo y le dijo "perdona, pero ya te has tomado un café hoy".

¿En serio? Si. En aquel estudio había una persona controlando quien se tomaba un descanso y quien no. Ya no merece la pena seguir hablando.

Yo trabajo para un estudio al que no le importa si me tomo un café o me tomo doscientos. Al que no le importa que en ocasiones esté dos horas seguidas o cuatro, en la cafetería. Porque cuando hago cualquier tipo de investigación, o busco referencias, no tiene ningún sentido estar delante de mi ordenador. Al que no le importa que a la hora de comer salga a hacer ejercicio, y llegue media hora tarde porque las duchas estaban ocupadas.

La produtividad no entiende de horarios, ni de lugares. Y si los responsables de producción no entienden esto, mal vamos.

Hoy en día, cuando alguien nos pide buscar referencias sobre algo concreto, la mayoría de la gente se va a Youtube y busca videos sobre una cascada, o sobre un tigre o sobre cualquier tema para el que necesite referencias e inspiración. ¿En serio? ¿Cómo vas a crear algo nuevo, diferente, original cuando estás utilizando referencias creadas por otro, interpretaciones de la realidad realizadas por alguien que no eres tu?. Cuando tu VFX Supervisor te pida que busques buenas referencias sobre chimpancés, tómate la tarde libre y vete al zoológico.

Formación

Yo quiero trabajar para un estudio que me forme, que me ayuda a ser mejor profesional. Un estudio que no se preocupa en absoluto de tu formación, y solo de sacar el máximo de tu persona para terminar su producto, es un sitio que no merece la pena, a mi almenos no me interesa.

Puede ser formación de cualquier tipo. Profesionales de otros estudios que vienen invitados a impartir workshops, supervisores de tu propio estudio que imparten formación especializada en areas alejadas a tu actividad diaria, formación creada para las necesidades específicas del estudio o producción, etc.

Si llevas más de doce meses seguidos en el mismo estudio y no has recibido ningún tipo de formación, pregúntate porqué. Puede que no te hayas interesado por ello (lo cual no tiene perdón) o puede que tu empresa no se haya interesado en ofrecértela.

En este sentido, siempre me viene a la mente aquella famos frase.

¿Qué ocurre si formamos a nuestros empleados, y se van?

¿Y qué ocurre si no los formamos y se quedan?

Revisión de contratos

Como mínimo, el estudio para el que trabaje ha de revisar mi contrato una vez al año. Analizar mi trabajo, y amoldarse en función de las tareas y responsabilidades que tenga dentro del estudio. Estas varían en función del proyecto, cada año tengo más experiencia y se gestionar mejor mi trabajo y el de mi equipo (si es que tengo uno) así que todo eso tiene que reflejarse en mi contrato, que al final, es lo único que importa.

En resumen, ha de existir comunicación entre artistas y recursos humanos. Éstos han de estar perfectamente informados de tu actividad dentro de la empresa, y a la hora de por ejemplo, pedir un aumento de sueldo, es necesario que tengan cuanta más información mejor, para que no pidas simplemente por pedir, y sin poder argumentar.

Esta repsonsabilidad es recíproca, ha de salir tanto de ti, como de ellos. Si no te han propuesto nunca hablar sobre tu trabajo, y revisar tus condiciones contractuales, toma tu la iniciativa.

Salario

Y fijáos que algo tan importante, quizás lo mas importante, no lo he puesto hasta ahora. Y eso es precisamente, porque considero que todas las cosas mencionadas hasta ahora, son más importantes para mi que el salario. Bueno, más o menos.

Lo que quiero decir es, el salario de uno va en función de la experiencia, y por experiencia no me refiero solo al número de años acumulados en tu curriculum, si no al tipo de proyectos realizados durante esos años. Si has trabajado en proyectos de alta complejidad en su ejecución, en proyectos laureados o realizando labores de mucha responsabilidad, tu experiecia se verá afectada positivamente. Si por el contrario, tienes veinte años de experiencia trabajando en proyectos menores y sin demasiada repercusión, tendrás dificil competir con alguien con la mitad de experiencia en proyectos y empresas de mayor nivel.

Dicho esto, tu salario más o menos será similar en un estudio u otro, teniendo en cuenta tu experiencia. Quizás el único diferenciador para que tu salario sea mejor, es si el estudio decide llamarte para ofrecerte trabajo. Esto generalmente ocurre cuando has trabajado previamente para un VFX Supervisor que quiere que vuelvas a formar parte de su equipo de trabajo. Si es así, tendrán que convencerte con algo, y una mejora salarial es un buen comienzo.

De no darse el caso, y si eres tu quien envia tu demo reel en busca de oportunidades, es muy probable que como vengo diciendo, el salario sea muy similar en un estudio o en otro. Siempre y cuando haya unos mínimos garantizados, el salario para mi es completamente secundario, y las pequeñas diferencias pasan a ser más importantes.

Pequeñas diferencias

Instalaciones. Para mi es muy importante que el estudio para el que trabaje tenga unas instalaciones adecuadas. Al final vamos a estar ocho horas al dia trabajando allí. En ocasiones diez, aveces doce horas diarias, puede que séis dias a la semana. ¿No crees que unas decentes instalaciones, unos buenos puestos de trabajo, etc, deberían de ser algo importante?

Sillas, mesas, buen sistema de calefacción y aire acondicionado, buenos equipos informáticos, buen soporte técnico, cocinas, comedores, etc.

Añadidos excepcionales. La bici es mi medio de transporte diario. Tener un parking para poder dejar mi bici con seguridad, y un vestuario con ducha para poder cambiarme, es vital para mi. No voy a ponerlo como algo básico, entiendo que no lo es, pero si en igualdad de condiciones un estudio ofrece este servicio en sus instalaciones y otro no, yo, me voy al primero.

Taxis, comidas, etc. Cuando trabajas durante largas jornadas, hay estudios que no se preocupan demasiado en cuidar a sus trabajadores. Como mínimo, comida y taxis deberían correr por parte del estudio si trabajas hasta tarde.

Creo que estas son más o menos las razones que les di a aquel grupo de alumnos, para justificar porque trabajo en un estudio como en el que trabajo. Por supuesto hay más, algunas de mayor peso que otras, pero ya me llaman en la puerta de embarque, próximo destino, Copenhage.

mmColorTarget

Este video es una pequeña demo que grabé hace tiempo explicando como utilizar el gizmo de Nuke "mmColorTarget" creado por Marco Meyer.

En el video explico primero como instalarlo en Mac, que no es cosa fácil. De hecho, si encuentras otra forma de hacerlo, agradecería que la compartieras.

Después, explico los usos que yo le doy en relación con referencias de texturas, background plates e Image Based Lightning.

El video originalmente fue creado para xuanprada.com así que está en inglés, aunque supongo no tendrás mayores problemas en seguirlo.

Gestión del color en efectos visuales

Conocer los aspectos técnicos detrás del color en efectos visuales es algo realmente complejo. La ciencia del color aplicada a la creación de imágenes sinteticas, es un tópico denso, complicado de entender (y explicar) y sin duda, yo no estoy capacitado para hacerlo de una forma correcta y precisa. Si realmente estás interesado en como funciona el color y como debemos utilizarlo en un pipeline complejo de VFX, te recomiendo que le eches un vistazo al paper publicado por VES, donde recoge en profundidad todos los tópicos que necesitas estudiar en relacion al color en el mundo audiovisual.

Lo que si voy a intentar explicarte de la forma más amena posible son los conceptos básicos y necesarios que considero cualquier VFX artist ha de comprender para poder desenvolverse con soltura en un pipeline de efectos visuales en cualquier estudio de VFX.

El color en efectos visuales parece ser un tema tabú, que mucha gente parece no comprender, otros ni siquiera están al corriente de como gestionamos el color en nuestros proyectos, y algunos, ni siquiera se interesan por el asunto. Tiempo atrás, algunos dejaron de trabajar en 8 bits y empezaron a trabajar de forma lineal. De esto hace años, y mucha gente hablaba de Linear Workflow, aunque la mayoría, se quedaron en como corregir los mapas de texturas para que su input fuese lineal y como renderizar imágenes flotantes de forma lineal sin hacer un bake de gamma.

Sin duda, es un paso, pero la mayoría de artistas siguen sin comprender los diferentes sistemas de color utilizados en VFX, incluso aquellos artistas trabajando en grandes VFX facilities. Muchos escuchamos términos como ACES o LUT, y realmente no sabemos que significan, o por qué debemos utilizarlos. Simplemente somos conscientes de que las imágenes mostradas en nuestro monitor de trabajo son diferentes cuando utilizamos un LUT u otro.

Por otro lado, profesionales trabajando en boutiques de VFX o estudiantes, nunca se han enfrentado a este tipo de terminología relacionada con el color, y cuando llegan a un estudio más grande, o simplemente han de colaborar en un proyecto global con varias boutiques, o realizan outsourcing para grandes estudios, etc. se topan directamente con algunos conceptos relacionados con el color que desconocen completamente.

Intentemos desde este blog arrojar un poco de información relacionada con este tema tan importante y necesario, siempre desde el punto de vista de quien escribe, un artista de efectos visuales, con las carencias que uno pueda tener en un campo tan complejo como la ciencia del color.

Asunciones generales

Como VFX artists vamos a tener que lidiar con diferentes tipos de material relacionados con color. Por simplificar el proceso digamos que tendremos que preocuparnos por recoger el material que viene de un set de rodaje, después tendremos que pensar en como almacenar ese material para poder utilizarlo a lo largo del pipeline de producción cinematográfica, después lo más importante será como poder visualizarlo correctamente, como trabajarlo en un entorno de VFX y finalmente, como distribuirlo para que pueda ser utilizado de forma correcta en las fases posteriores a la realización de los efectos visuales.

En set de rodaje, lo más importante relacionado con color son las fuentes lumínicas artificiales y las cámaras. Temperatura de color y tintado son las propiedades más importantes de las que debemos estar al tanto. Siempre necesitaremos Macbeth Charts y otros color samples para poder trabajar el color grading de forma correcta. La resolución y profundidad de color del material rodado también cobra importancia cuando trabajamos con color. LED, tungsteno, Kinoflo, etc. cada fuente lumínica tiene propiedades diferentes que tenemos que conocer para poder trabajar con los diferentes recursos de forma correcta, eficaz y sobre todo, consistentemente.

- Todos los estudios de VFX son diferentes.

Todos los estudios de VFX para los que he trabajado y con los que he trabajado, abordan la gestión de color de forma diferente, lo que me hace pensar que nadie trabaja de la misma forma. Es lógico, cada estudio (especialmente los grandes) utilizan un montón de herramientas propias que requieren ser tratadas de forma extraordinaria.

Como bien sabéis, no hay un solo proyecto que se realice de forma íntegra en un solo estudio de VFX, así que siempre toca lidiar con pipelines de color de otros estudios, ya que se comparten assets y otros materiales entre varios facilities.

- 8 bits

En el pasado solíamos trabajar en sistemas de color de 8 bits. Sin entrar en mucho detalle, digamos que solíamos bakear un gamma en la imagen de salida, esto permitía que las imágenes producidas se pudiesen representar bien en los dispositivos utilizados, tv, cine, monitor, etc. Podemos referirnos a este sistema de trabajo como sRGB pipeline.

No creo que quede un solo estudio sobre la faz de la tierra trabajando en 8 bits. Todos ya trabajamos de forma linear. Supongo que tu también.

- Physical Based Workflow

Hoy en día, prácticamente todos los estudios tienden a trabajar en un physical based workflow, donde todo el material se interpreta de forma linear. Footage, texturas, luces, shaders, renders, composición, etc. todo es o se convierte a linear para que los cálculos sean correctos. Nos referimos también a este sistema de trabajo como High Dynamic Range Pipeline o simplemente Linear Pipeline.

Cuando trabajamos en un Physical Based Workflow entendemos que utilizamos Plausible Lighting, Physical Based Shading y Physical Based Lighting and Rendering.

- Luts

Luts o Look Up Table, son por resumirlo mucho, archivos digitales que simulan la emulsión de una película fotográfica existente o inventada. Es decir, cuando aplicamos un LUT a un footage o a un render, éste va a cambiar en función del LUT aplicado. Los LUTs cambian en función del show y generalmente son elegidos por el cinematógrafo antes de rodar el proyecto. La productora se encargara de proporcionar el LUT utilizado a los diferentes departamentos que figuran en la producción cinematográfica, como VFX, editing, o DI.

En efectos visuales es extremadamente importante trabajar siempre con el LUT del show aplicado, ya que el resultado tras aplicar el LUT en ocasiones es extremadamente diferente. Es por esto que por ejemplo aplicaciones como Photoshop han quedado prácticamente desterradas de los pipelines de VFX, ya que no tienen soporte para LUTs y otros sistemas de color de los que hablaremos más adelante.

- Gamut

El gamut es el rango de color disponible en una imagen. Este rango de color puede variar de forma considerable en función del espacio de color utilizado. A continuación hablaremos de diferentes espacios de color.

Múltiple información, múltiples software

Independientemente de cual sea nuestro pipeline de VFX vamos a necesitar utilizar una cantidad de software ingente y tendremos que utilizar y generar todo tipo de información visual.

Partiremos seguramente de scans o footage de alta resolución (4k o 6k) en diferentes formatos y espacios de color, pero siempre con un rango dinámico muy alto. Muchas veces estos scans no son puramente digitales, aún se ruedan muchísimas películas en film, así que los scans puede que sean negativos escaneados.

También tendremos que trabajar con footage en 8 bits, con imágenes, HDR, con imágenes LDR, con texturas de todo tipo, etc.

Cuando hablamos de software, utilizaremos software comercial como Maya, Nuke, Mari, Arnold, Vray, RenderMan, Clarisse, Katana, Houdini, etc. Cada uno de estos paquetes son perfectamente capaces de gestionar color para VFX de diferentes formas. Además de todos los mencionados anteriormente, la mayoría de estudios de efectos visuales utilizan software propietario para cubrir sus necesidades más especificas.

En resumen, hay un montón de variables relacionadas con el color en nuestro pipeline, y si no las conocemos y si no somos consistentes a la hora de trabajar con color, seremos incapaces de realizar nuestra labor como VFX artists.

Output

Los efectos visuales no son el final del proceso cinematográfico, como muchos pueden pensar. Tras terminar los VFX de cualquier película, el material generado por el estudio al igual que el resto del footage rodado, pasan a la sala de DI (Digital Intermediate) donde el color va a sufrir importantes modificaciones artísticas en base a las opiniones subjetivas del director, el cinematógrafo y el colorista.

Si el material proporcionado por el estudio de VFX no tiene la suficiente calidad e información de color, cuando este sea manipulado en la sala de DI, empezaran a aparecer todo tipo de artefactos, banding, etc. así que tenemos que asegurarnos de que el material que generemos como VFX artists cumpla con los requisitos necesarios.

Ciencia del color

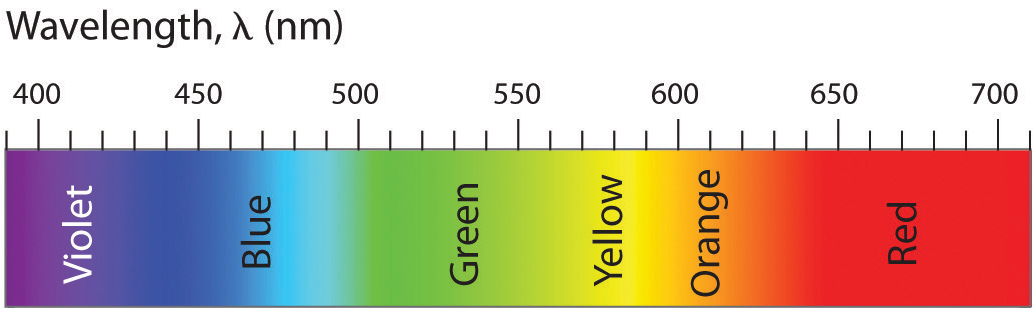

La energía de la luz puede medirse con la siguiente gráfica de longitud de onda o wavelength cuyas unidades son nm.

El espectro visible que el ojo humano es capaz de apreciar oscila entre 380nm y 780nm.

El sistema de vision humano es tricromático y ha sido mapeado al sistema de color CIE 1931 para que podamos medir colores físicos puros (wavelenght) en señales electromagnéticas correspondientes al espectro visible humano.

En las imágenes más abajo, tenemos representado el espectro en su totalidad. El triángulo mas grande corresponde al espectro visible humano, prueba de que no somos capaces en entender visualmente toda la información existente en la naturaleza.

El triángulo mediano, corresponde al gamut representado en el espacio de color REC 709 o también llamado HDTV

En las dos imágenes de abajo, podemos ver a la izquierda el gamut en el espacio de color sRGB y a la derecha, en el espacio de color CIE RGB. Lo que esto pone de manifiesto es que en función del espacio de color que utilicemos, vamos a ser capaces de revelar de forma directa más o menos información, con los pros y contras que ello conlleva.

RGB es un sistema de codificación de color que utiliza colores primarios (rojo, verde y azul) para crear un gamut específico. Recuerda que el gamut es el rango de colores, y que como hemos visto, varía en función del espacio de color utilizado. Este look basado en coloes primarios está obligadamente ligado al dispositivo donde se muestran las imágenes, nunca se ven de forma linear, siempre necesitan de un espacio de color pasa ser representados de forma correcta.

Display (sRGB) vs Scene (Linear)

Los espacios de color diseñados en relación con el dispositivo donde se van a representar imágenes, son llamados Display Referred, y varían como decimos, en función del dispositivo. Monitor, iPad, proyector, etc.

- En cuanto a colorimetría se refiere, se define en función de lo mostrado en pantalla.

- El rango dinámico es el que se ve en pantalla, no hay más.

- sRGB se utiliza como espacio de color en dispositivos RGB (gamma 2.2).

- Requiere de linearización (gamma inversa).

Los espacios de color diseñados para dispositivos de entrada son llamados Scene Referred.

- Los valores no son definidos en base a imagen en pantalla si no en base a unidades globales del mundo real.

- Se trabaja de forma linear.

- No hay valores máximos, por eso imágenes HDRI tienen valores extremadamente altos.

- Nos referimos a sus valores mediante stops, no mediante valores numéricos de pixels. No hablamos de contraste en términos de 1000:1 si no en términos de rango dinámico. A fin de cuentas, este es el lenguaje cinematográfico y cuando un cinematógrafo dice "aumenta 1 stop" se refiere a que dobles la iluminación de la escena.

- Para poder visualizar correctamente Scene Referred material, necesitamos aplicar un tone mapping a las imágenes, ya que si no, se verían demasiado oscuras. La mayoría de monitores no son capaces de visualizar imágenes lineares, por eso tenemos que aplicar tone mapping para poder visualizar imágenes HDR en monitores LDR.

- Un mínimo de 16 bits es necesario para trabajar con este tipo de imágenes.

Log

En ocasiones puede que nos encontremos con ficheros Log de 10 bits. En su día fueron el sistema estándar a través de Cineon y DPX aunque han sido prácticamente sustituidos por Floating Point .EXR

Generalmente cuando vemos este tipo de imágenes en un monitor RGB aparecerán completamente lavadas, es necesario visualizarlas con una codificación apropiada.

ACES y OPENCOLOR IO

Academy Color Encoding Space es un "nuevo" sistema de gestión de color que muchos estudios de VFX ya utilizan, guarda toda la información en Open EXR.

El espacio de color es High Dynamic Range o Scene Referred Linear Space, lo que quiere decir que el gris medio sera de 0.18 y no de 0.5

En la imagen de abajo se puede ver que el gamut o rango de color, es tan grande como el propio espectro visible.

OPENCOLOR IO es otro pipeline de color open-source adoptado por varios estudios de VFX cuyas mayores ventajas son la unificación de transformaciones y visionados de color entre múltiples plataformas y aplicaciones, lo que asegura una mayor estandarización.

¿Y en mi casa qué?

En tu casa has de trabajar siempre de forma linear. Si no partes de material linear tendrás que convertirlo.

Las operaciones en el motor de render siempre ocurren de forma linear, y tanto los inputs como los outputs han de ser lineares.

Si por ejemplo estás pintando texturas en Mari, hazlo en 16 bits (o 32 si es necesario) y expórtalas en formato .EXR

Si por el contrario, partes de fotografías descargadas de internet, estas serán de 8 bits .jpg por ejemplo. Así que deberás de linearizarlas antes de poder renderizarlas. Basta con añadir una función gamma 2.2 inversa. El siguiente gráfico muestra a la perfección como han de ser los inputs y los outputs.

Siempre vas a renderizar de forma linear y para poder visualizar tus renders de forma correcta simplemente has de utilizar el espacio de color apropiado para tu dispositivo. Generalmente sRGB.

En el caso de utilizar un LUT concreto, simplemente selecciónalo en Maya, en Nuke, en Mari o en el software que utilices. Lee la docuemntación de tu motor de render favorito para entender como interpreta la gestión de color.

Nueva gestión de color en Maya 2016

Cada software es único y la gestión del color se hace diferente dependiendo del producto y la versión. Vamos a ilustrar como funciona en Maya 2016, por aquello de ser el software standard en la industria y además, incorporar un nuevo sistema de gestión de color en esta nueva versión 2016.

- En las preferencias, asegúrate de tener activado Enable Color Managment.

- En el apartado Color Transformation, has de tener como Rendering Space linear sRGB, también podrías utilizar otros espacio de color si fuese necesario, como ACES, REC, CIE, etc. Seguramente en tu casa sólo vayas a utilizar linear sRGB.

- En la opción View Transform, utilizarás sRGB ya que vas a visionar tus imágenes en un monitor LDR. Podrías utilizar RAW en el caso de utilizar un monitor HDR o LOG por ejemplo. Pero generalmente en casa, no vas a utilizarlos.

- Existe la opción utilizar un pipeline OCIO y una ruta para seleccionar el archivo proporcionado para la producción.

- También existe la opción de indicar el espacio de color por defecto de tus imágenes. Puedes seleccionar sRGB o Linear. Por supuesto depende de tu pipeline de texturizado, generalmente en un VFX facility será Linear.

- En el apartado Output, existe la opción de hacer un bake de gamma al render final. Nunca vamos a utilizar esto.

- Un poco más abajo existe la opción de utilizar un fichero LUT, cuando sea necesario este será el lugar de colocarlo.

- El último setting que podemos necesitar es el llamado Show Color Managed Pots, para corregir por ejemplo, color swatches en los shaders.

- En este ejemplo, tengo dos MacBeth Charts completamente idénticas, la de la izquierda es una imagen de 8 bits en espacio de color sRGB .jpg. La imagen de la derecha es una imagen linear float point 16 bits .exr. Como puedes comprobar se visualiza de forma incorrecta en el visor de imágenes de OSX, porque éste no tiene forma de transformar el espacio de representación, como haría por ejemplo Nuke.

- Si queremos aplicar estas dos texturas en un pipeline de color linear, la imagen de la derecha funcionaría perfectamente, la imagen de la izquierda necesita ser linearizada.

- Para ello puedes añadir un inverse gamma de 2.2 (0.455) o cambiar el color space en el attribute editor a sRGB. En el caso de utilizar una imagen linear .exr deberíamos utilizar la opción RAW. Si utilizamos un pipeline linear, no necesitaríamos cambiar el color space de las imágenes lineares, ya que por defecto, hemos indicado en las opciones de Maya que estamos trabajando de forma linear.

Espero que haya quedado un poco más claro como gestionamos en color en proyectos de efectos visuales.