Ejercicio de fotogrametría, parte 01

Hace ya algunos años, publicamos en este blog un completísimo curso online sobre photogrammetry, o fotogrametría (parece ser) en castellano. Desde entonces han aparecido nuevos software, alguna que otra herramienta, y quizás algunos de los procesos han cambiado ligeramente, aunque nada revolucionario, la verdad. Por mi parte, hace tiempo que no trabajo en un proyecto donde requiera de la captura de assets mediante fotogrametría, el útimo show en el que utilicé de forma notoria técnicas de fotogrametría fue Assassin´s Creed.

En aquella ocasión capturé y recreé posteriormente parte del vestuario y props utilizados por Michael Fassbender y Ariane Labed. Tras aquel trabajo, no he realizado más que tareas muy esporádicas y sencillas, en cuanto a fotogrametría se refiere. Aun así, he ido seguiendo nuevas técnicas, herramientas y formas de hacer las cosas, y practicando algunas de ellas cuando el tiempo me lo ha permitido.

En un futuro, pretendo crear un nuevo curso de fotogrametría, expandiendo los conocimientos adquiridos en el primer curso publicado, y actualizando todo aquello que ha cambiado durante estos años. En este post, y en una serie de post que vendrán en un corto periodo de tiempo, pretendo mostraros a aquellos que no tengáis demasiada experiencia en técnicas de fotogrametría, como capturar un par de assets sencillos, utilizando para ello diferentes técnicas y herramientas. Hay que tener en cuenta que no todas las tareas de fotogrametría son iguales, y que no se aplican de la misma forma en todas las industria. Por ello, siempre estaré hablando desde el punto de vista de efectos visuales.

Pasaremos por todas las fases comunes de un proyecto de fotogrametría, incluyendo captura, shooting pattern, color correction, software de fotogrametría, reconstrucción del asset, clean-up, retopología, de-lighting, texturizado, look-dev, y render test.

Este es el asset que pretendemos capturar, una roca incrustada en el suelo. No nos preocuparemos de la hierba, simplemente de la superficie rocosa. Siempre que capturo un asset, hago una fotografía de contexto o staging, simplemente para mostar cual es el asset a capturar y el entorno que le rodea, para tener en cuenta el contexto de cara a una futura reconstrucción.

Los suscriptores de elephant vfx pro, podéis descargaros las fotografías raw para trabajar en este proyecto.

Este tipo de assets son muy sencillos de capturar. Basta con hacer un “turntable” con un par de alturas diferentes. Sin necesidad de utilizar trípode. El único equipo utilizado es una Sony A6000 con un milti zoom y una Macbeth Chart. También conviene utilziar sistemas de medición o escala a la hora de captuar. En este caso no he utilizado ninguno, pero siempre tengo un macbeth chart en frame, con tamaño conocido, así que puedo escalar el asset para obtener una escala real posteriormente.

Los settings de cámara, para este caso en particular, son extremadamente básicos. Fstop 11, ISO 300, aperture priority, es decir, ajuste automático en función de la apertura. White balance fijo, no importa cual (disparamos raw), en este caso nublado, y foco automático. La iluminación es natural, así que no nos preocupamos en ese aspecto. Como decía, este es el “pattern” utilizado para realizar las fotografías.

Mi organización de ficheros, por el momento al menos, es muy sencilla. Diferentes directorios para cada tipo de formato fotográfico.

Quiero utilizar la herramienta color checker passport para calibrar el color de mis fotografías adecuadamente, pero para ello necesito antes convertir las fotografías a DNG. No es necesario convertir toda la secuencia, basta con convertir una sola fotografía en la que el Macbeth chart esté en foco y bien expuesto. Una ve convertida, podemos utilizar la herramienta color checker passport con ella.

Automáticamente los swatches del color chart serán seleccionados, de no ser así puedes ajustarlos a mano. Una vez hecho esto, el software ajustará los valores de los swatches de la fotografía acorde a los valores de medición ideales del fabricantes del color chart. Y con ello crearemos un perfil de cámara que reutilizaremos posteriormente en Adobe Camera Raw para aplicar a todas las fotografías del shoot.

Una vez creado el perfil de cámara, abrimos la fotografía con Adobe Camera Raw. Lo primero que necesitamos hacer es aplicar el perfil creado anteriormente.

Lo que pretendemos con este proceso es linearizar la imagen. Linearizar es un término utilizado para diferentes propósitos en vfx, en este caso nos referimos a dejar la imagen lo más neutra posible, entendiendo por neutra, plana.

El tipo de curva debe ser linear, para que la transformación aplicada sea lo menor posible, y todos los ajustes deberán desactivarse para neutralizar la imagen de la mejor forma posible.

Ahora toca utilizar al herramienta white balance para eliminar la mayor parte de transformación de color aplicada por tu cámara, en este caso, la mia :)

Después, selecciona dos o tres swatches para matchear los valores proporcionados por el fabricante, en este caso 243, 160 y 52 aproximadamente. Una vez terminado, hacemos click en “done” y toda la información será guardada en los meta datos de la imagen.

Abrimos todas las imágenes en Lightrooms y sincronizamos los settings acorde a la imagen DNG que hemos corregido en Adobe Camera Raw. De esta forma todas las imágenes, que han sido realizadas bajo las mismas condiciones lumínicas y con casi idénticos settings de cámara, vivirán en el mismo contexto. Las imágenes resultantes las exportamos como .JPG El software de fotogrametría, aunque entiende imágenes de alto rango dinámico, no lo utiliza para nada, así que siempre vamos a utilizar imágenes de bajo rango dinámico. El resultado será el mismo pero el tiempo de computación será mucho menor.

Como software de fotogrametría en este particular ejemplo, vamos a utilizar Agisoft photoscan. Las licencias personales son realmente asquibles, y los resultados obtenidos en este software son excelentes. El otro software hot del momento es Reality Capture, que es considerablemente más caro, pero muchísimo más rápido, especialmente cuando trabajamos proyectos con varios cientos de fotografías.

La rapides, es lo único que en mi parecer es mejor en Reality Capture que en Photoscan, el resto, prefiero Photoscan. En el futuro utilizaremos Reality Capture para varias tareas.

Nota importante, Reality Capture no está disponible ni para Mac ni para Linux.

Lo primero que conviene realizar en Photoscan es analizar la calidad de las fotografías y descartar aquellas por debajo de 0.2

Este asset es muy sencillo, y no utilizamos ningún setup especial para capturar las imágenes, así que poco más necesitamos hacer en Photoscan. Tenemos que alinear las imágenes en primera instancia. Tenemos unas 90 imágenes, con suficiente overlapping entre ellas, así que la tarea de alineación se con total seguridad que será un éxito. Procursa siempre realizar suficientes fotografías para generar un point cloud suficientemente detallado.

Tras unos minutos las fotografías son alineadas y una cámara es virtual por cada disparo. En esta ocasión todas las cámaras han sido perfectamente alineadas, sin ningún descarte. Sinónimo de que el material fotográfico es bueno.

El siguiente paso es generar el point cloud. Este es el proceso que más tiempo requiere, en mi caso, utilizando un iMac 2013 ha tardado alrededor de 4 horas y media. Conviene utilizar la calidad más baja posible, simplemente para testear que todo funciona correctamente. Con esta calidad tardará apenas uno minutos. Si prevees que todo está ok, utiliza calidad alta y genera el point cloud.

Una vez terminado el proceso, podremos ver un point cloud, incluyendo vertex colors (no teturas) bastante detallado. Eso simplemente es un point cloud, aun tenemos que generar el mesh y las texturas. La densidad del mesh dependerá de la calidad del point cloud generado.

Una vez finalizada la generación del mesh y de las texturas, podemos exportar el proyecto mediante .fbx de esta forma conseguiremos la geometría y las cámaras para su posterior utilización en Maya, Mari, etc. Ten en cuenta de que tanto el mesh como las texturas son simplemente placeholder, vamos a generar un mesh y unas texturas aptas para el trabajo de producción. Lo que estamos exportando desde Photoscan no nos sirve para viajar a traves del pipeline de vfx.

Importamos en Maya el .fbx y obtenemos el mesh, las texturas y las cámaras. Para alinear o escalar el asset es muy importante agrupar todo el contenido dentro de un locator o similar. Necesitamos las transformaciones originales para seguir trabajando el asset en el futuro.

Continuaremos trabajando este asset en el siguiente post.

Los suscriptores de elephant vfx pro, podéis descargaros las fotografías raw para trabajar en este proyecto de fotogrametría.

5D Mark III vs Ricoh Theta - día soleado

En alguna ocasión anterior ya hemos hablado sobre el uso de Ricoh Theta para tareas de image acquisition en efectos visuales. En ese video ya comentaba algunos de los puntos fuertes y débiles de utilizar un setup convencional vs un setup basado en Ricoh Theta. Te recomiendo echarle un vistazo.

En esta ocasión, he realizado un ejercicio de image acquisition, donde la fuente lumínica principal es muy potente, el sol, y por lo tanto, es muy importante capturar el mayor rango dinámico posible, para así poder representar de forma efectiva la situación lumínica capturada de forma virtual.

Los setups a comparar son

- Canon 5D Mark III + 8mm fish eye + panoramic head

- Ricoh Theta S + Manfrotto mini tripo

- Los dos anteriores se complementan con lighting checkers y macbeth chart.

Las imágenes capturadas con el setup tradicional. 6 ángulos (aunque podrían haber sido solamente 3). 7 exposiciones por cada ángulo con 2 stops de diferencia. En total 42 imágenes.

Settings de cámara

- ISO: 100

- Apperture: f22

- Mid exposure: 1/100

- 2EV apart

- Min exposure: 1/6400

- Max exposure: 0''6

- White balance, focus, etc = manual

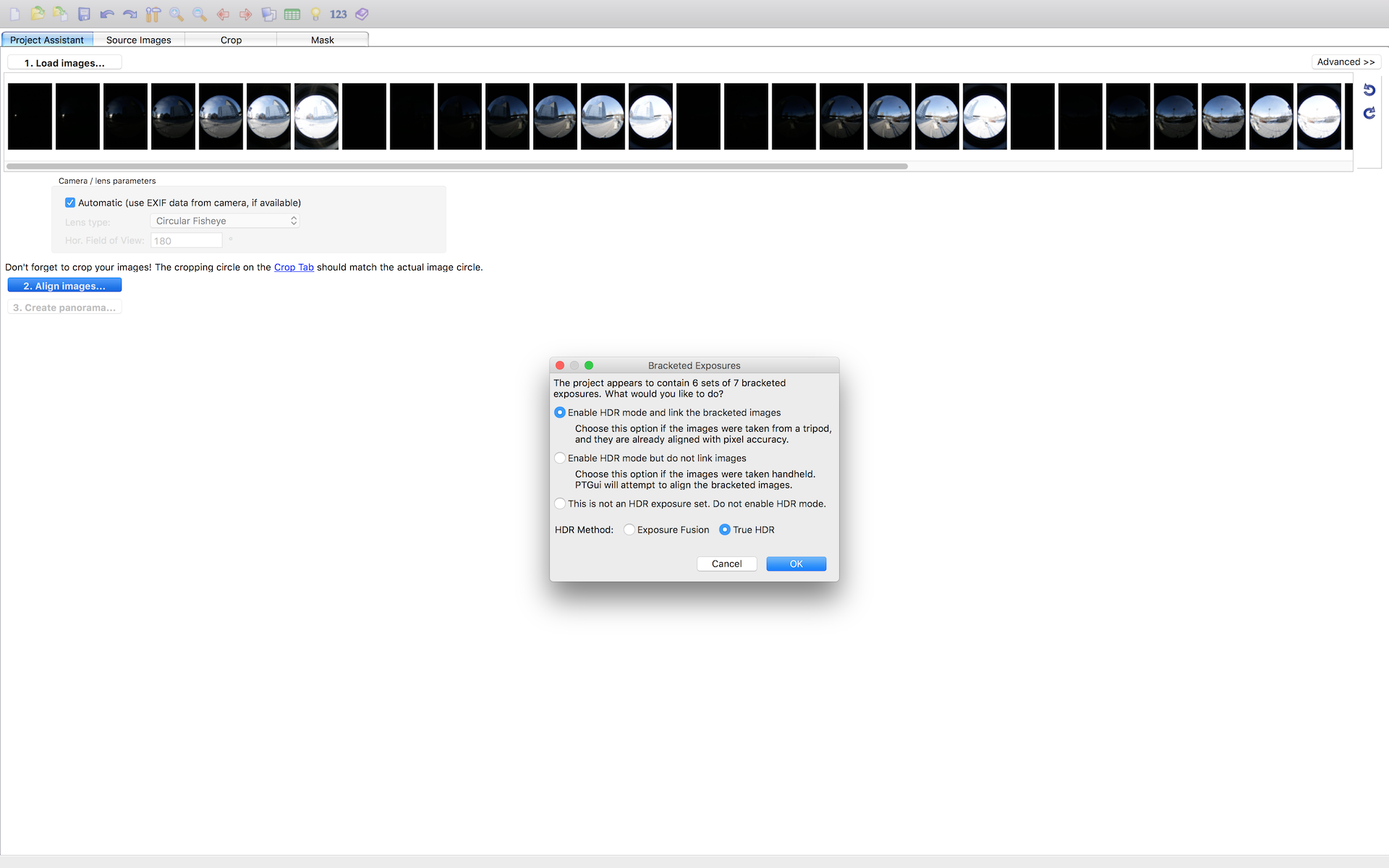

Todos mis brackets están perfectamente alineados, ya que las fotografias se realizaron con un pano head. De esta forma no es necesario perder ni 2 minutos en Ptgui para hacer el stitching.

Las fotografías realizadas con Ricoh Theta, son completamente automáticas, no se pueden controlar de forma manual. Los settings generados son:

- Min exposure: 1/6400

- Max exposure: 1/100

El stitching en este caso, lo hago con Merge HDR Pro en Photoshop, ya que Ptgui no hace stitching de fotografías equirectangulares, (si rectilíneas y fish eye). Nunca deberías utilizar Photoshop para trabajo de datos, así que una vez generado el HDRI guarda como .exr y nunca más la abras en Photoshop.

Me llevo los dos panoramas a Nuke, para neutralizarlos en base a mis referencias. También para limpiar artefactos si fuese necesario, aunque en este caso he pasado olímpicamente de ello.

Si bajamos la exposición en viewport y analizamos el punto de mayor valor lumínico en la imagen, es decir el sol, veremos la brutal diferencia entre un panorama y otro.

- 5D Mark III = 431

- Ricoh Theta: 3.8

Esta información ya debería de ser una valiosa pista del comportamiento de un panorama u otro cuando creemos nuestros setup IBL.

Ya en Maya, creo dos setups de IBL diferentes, uno para cada panorama. Las diferencias son evidentes, especialmente en la densidad de las nombras y la distribución de la luz.

5D Mark III

Ricoh Theta

¿Eres suscriptor de elephant vfx pro? Descárgate el material utilizado en este post y analízadlo tranquilamente en tu casa.

Ricoh Theta lighting acquisition VFX

En este video os explico como utilizo la cámara Ricoh Theta para VFX lighting acquisition. Además os muestro el proceso de creación de un rig image based lighting utilizando el material capturado.

Este es el equipo utilizado.

Captura de pantalla de Nuke.

Captura de pantalla de Maya.

Render realizado durante el ejercicio.

Los miembros de elephant vfx pro podéis descargaros el material de trabajo desde vuestra cuenta.

Neutralización de referencias fotográficas

En este vídeo muestro como neutralizar referencias fotográficas para mantener la consistencia entre imágenes fotografiadas en set. A diferencia de como muestro en algunos de mis cursos, en esta ocasión no utilizo Nuke, si no que, utilizo Adobe Lightroom, ya que en muchas ocasiones no dispondras de Nuke en un set de cine.

También anuncio un nuevo proyecto formativo que me estoy planteando para elephant vfx.

On-set tips: Crear high frequency detail

Nota: Este post incluye contenido exclusivo para los suscriptores de elephant vfx pro. (enlaces al final del post).

En un post anterior ya mencionamos de la importancia del "high frequency detail" a la hora de escanear assets mediante técnicas de photogrammetry. En esta ocasión, explicamos como escanear assets cuando estos carecen de detalle de superficie y de detalle de color.

Es bastante común en cine tener que escanear props que se utilizan para rodar ciertas escenas, pero que en ningún caso salen en pantalla, ya que serán creados 100% de forma digital. Estos props, generalmente realizados con algún tipo de resina, no se pintan, se mantiene su color natural, ya que eso abarata la producción del propio pro.

Escanear mediante photogrammetry superficies sin ningún tipo de detalle, es por definición imposible. Primero, es muy difícil enfocar, ya que no existen puntos de referencia claros. Y segundo, el software de photogrammetry no podrá analizar puntos comunes entre las diferentes fotografías.

Supongamos que queremos escanear esta máscara, ya que necesita ser extendida de forma virtual. Como véis, es completamente blanca, sin ningún tipo de detalle de superficie. Necesitamos crear "high frequency detail". Este es un caso práctico de producción, similares situaciones ocurrieron por ejemplo en los sets de Batman o IronMan.

El equipo necesario es muy compacto. Basta con una DSLR y lente, tripode con soporte para el prop, y dos pinturas diferentes. Por un lado tengo un neutral grey para cubrir el prop, y por otro lado tengo una pintura verde para crear el detalle.

Con mi soporte especial y blu-tack puedo facilmente fijar el prop al tripode.

Con la pintura gris cubro por completo el prop. Con este color me aseguro una exposición mejor balanceada que con el color blanco original.

Una vez seca la pintura gris (se puede utilizar un secador de pelo para acelerar el proceso) paso a cubrir con puntos verdes toda la superficie, creando asi suficientes puntos de contacto para el software de photogrammetry y tambien para el enfoque de camara.

Una vez procesado el material fotografico, obtenemos un scan perfectamente valido para reproducir el prop de forma virtual con total exactitud.

Los suscriptores de elephant vfx pro podéis desde aquí acceder a un video donde expandimos estos tópicos.

Manfrotto Befree

Otra aporte que nos gustaría realizar a este blog / repositorio de formación, son reviews y análisis de hardware y software que nos parecen interesantes y recomendables.

Procuraremos recomendar sólo aquellos productos que utilicemos o que al menos, hayamos visto utilizar de cerca. No tenemos previsto hablar de productos promocionados, es decir, aquellos que paguen para que hablemos de ellos. Lo que si puede ocurrir, es que hablemos de productos que hayan sido donados al blog para poder utilizarlos y beneficiarnos de sus características.

En esta ocasión quiero hablaros de una de las herramientas que más utilizamos on-set, los trípodes de la familia Befree de Manfrotto. Son probablemente los trípodes más compactos que se pueden encontrar en el mercado en este momento. Disponibles tanto en aluminio como en fibra de carbono. No voy a hablar mucho más de sus características técnicas, para ello basta con que accedáis a la web oficial del producto. En estas reviews más que centrarme en el producto en si pretendo hablar del uso que le damos en elephant vfx.

Como decía, la principal característica de estos trípodes es que son muy pequeños cuando están plegados y de tamaño medio cuando están completamente extendidos. Además, incluyen una ball head y un quick release plate, todo por un precio muy asequible.

¿Para qué los utilizamos en elephant vfx?

Los utilizamos en muchas tareas on-set relacionadas con efectos visuales, principalmente como trípodes secundarios. Se pueden utilizar perfectamente como trípodes principales, pero tienen un punto flaco importante; no son demasiado estables cuando han de soportar mucho peso. Esto quiere decir que una reflex digital de gama alta con un multi zoom puede ser una combinación poco recomendable. No hay problema en utilizar este equipo fotográfico con estos trípodes, pero siempre disparando con un remote trigger para evitar tocar la cámara. Bracketing queda prácticamente descartado utilizando multi zooms, ya que la vibración de la cámara entre cada uno de los brackets hará que se mueva ligeramente el trípode, descuadrando la alineación de los brackets. Bracketing con prime lenses como 28mm o 50mm se puede realizar a la perfección.

Dicho esto, una de las tareas que realizamos con estos trípodes es fotogrametría on-set para entornos o props medianos-grandes que necesiten mover el trípode alrededor del sujeto. Especialmente realizamos esta tarea con cámaras compactas mirrorles y prime lenses, como Sony A7 o Sony a6000. Esta combinación de equipo fotográfico y trípode resulta en una solución móvil perfecta para moverse alrededor del set.

Además de tareas de fotogrametría, también utilizamos Manfrotto Befree como soporte para lighting checkers, tanto Mono como Twins. De nuevo, debido a su reducido tamaño, su ligereza y su capacidad de extensión, podemos colocar los lighting checkers en cualquier posición deseada. Incluso cuando sólo disponemos de un par de mochilas o maletas para transportar todo el equipo fotográfico necesario, podemos fácilmente llevar dos o tres de estos trípodes para las diferentes tareas.

También los utilizamos como soporte para turntables de fotogrametría. Aquí dejo una foto de un Befree con un turntable Akromatic. Gracias a las diferentes opciones de expansión, podemos colocar el trípode en el suelo, en una mesa o donde necesitemos en el set, adecuando el trípode a la iluminación presente, en el caso de no poder modificar la misma.

Otro uso que le damos a estos trípodes, es el de soporte para panoramic heads para realizar HDRIs panorámicos. Si bien como dije antes, no son el tipo de trípodes más estables, con programar la cámara para esperar dos o tres segundos entre cada uno de los brackets, no tendremos mayores problemas. Utilizar panoramic heads más compactas que Nodal Ninja también ayuda. Generalmente las DSLR profesionales son pesadas, pero los fisheye lenses suelen ser compactos. Así que no es una combinación demasiado peligrosa.

También utilizamos estos trípodes como soporte para plataformas adicionales, bien sean para ordenadores portátil o para tomar notas.

Finalmente, utilizamos Befree para cualquier cometido de fotografía principal de referencias, simplemente para tener una cámara montada en el set y estar listo para tomar referencias en cualquier momento.

Dato importante a tener en cuenta, Hay una versión más pequeña que otra. Ambos vienen con ball heads y quick release plates, pero, en la versión mas pequeña no se puede intercambiar la cabeza, está fija y no se puede quitar. Esto reduce mucho las posibilidades de utilización del trípode, ya que sólo podrás utilizarlo con cámaras y accesorios donde puedas colocar un quick release plate. Este trípode en particular, yo sólamente lo utilizo para tareas de fotogrametría con cámaras mirrorless. Ambos trípodes vienen con sus respectivas fundas (que no utilizarás nunca).