Trabajando con lidars

Hola patrons,

En este video vamos a hablar sobre lidar scanning. Hemos hablado de forma esporádica en este canal sobre lidars, pero nunca en profundidad. En este video de unas 3 horas vamos a hablar en detalle sobre el procesado y uso de lidars en la industria del entretenimiento.

Lidars scans se utilizan en absolutamente todos los proyectos en los que trabajamos, y los contamos por docenas en cada producción, así que considero que se trata de un tema importante con el que tarde o temprano tendras que lidiar en tu trabajo.

En este video hablaremos de:

- Qué son los lidars.

- Cómo utilizamos lidars en VFX.

- Cómo funciona la tecnología lidar.

- Nociones básicas de trabajo en set.

- Hardware.

- Sofware.

- Cómo procesar point clouds.

- Cómo generar 3D meshes.

Toda la info en mi canal de Patreon.

Un saludo a todos!

Xuan.

Ricoh Theta en condiciones lumínicas complicadas

Llevamos al extremo la Ricoh Theta, tratando de capturar condiciones lumínicas complicadas. Para ello, nos aprovechamos del último firmware de la cámara y la última actualización de la app que controla la cámara de forma remota.

Te cuento mis impresiones, y te muestro los resultados obtenidos. Además, también podrás descargarte el material utilizado en el post para hacer tus propias pruebas.

Este es un post exclusivo para los usuarios de elephant vfx pro. Desde vuestra página de contenidos podéis acceder al artículo.

Mono White

Desde akromatic presentamos el lighting checker "Mono White" mitad gris neutro y mitad blanco matte (N10). Este checker empezó como solución personalizada para uno de nuestros production VFX supervisors en Netflix y por "demanda popular" hemos decidido añadirlo a nuestro catálogo permanente de lighting checkers.

Mas información y compra en la web de akromatic.

5D Mark III vs Ricoh Theta - día soleado

En alguna ocasión anterior ya hemos hablado sobre el uso de Ricoh Theta para tareas de image acquisition en efectos visuales. En ese video ya comentaba algunos de los puntos fuertes y débiles de utilizar un setup convencional vs un setup basado en Ricoh Theta. Te recomiendo echarle un vistazo.

En esta ocasión, he realizado un ejercicio de image acquisition, donde la fuente lumínica principal es muy potente, el sol, y por lo tanto, es muy importante capturar el mayor rango dinámico posible, para así poder representar de forma efectiva la situación lumínica capturada de forma virtual.

Los setups a comparar son

- Canon 5D Mark III + 8mm fish eye + panoramic head

- Ricoh Theta S + Manfrotto mini tripo

- Los dos anteriores se complementan con lighting checkers y macbeth chart.

Las imágenes capturadas con el setup tradicional. 6 ángulos (aunque podrían haber sido solamente 3). 7 exposiciones por cada ángulo con 2 stops de diferencia. En total 42 imágenes.

Settings de cámara

- ISO: 100

- Apperture: f22

- Mid exposure: 1/100

- 2EV apart

- Min exposure: 1/6400

- Max exposure: 0''6

- White balance, focus, etc = manual

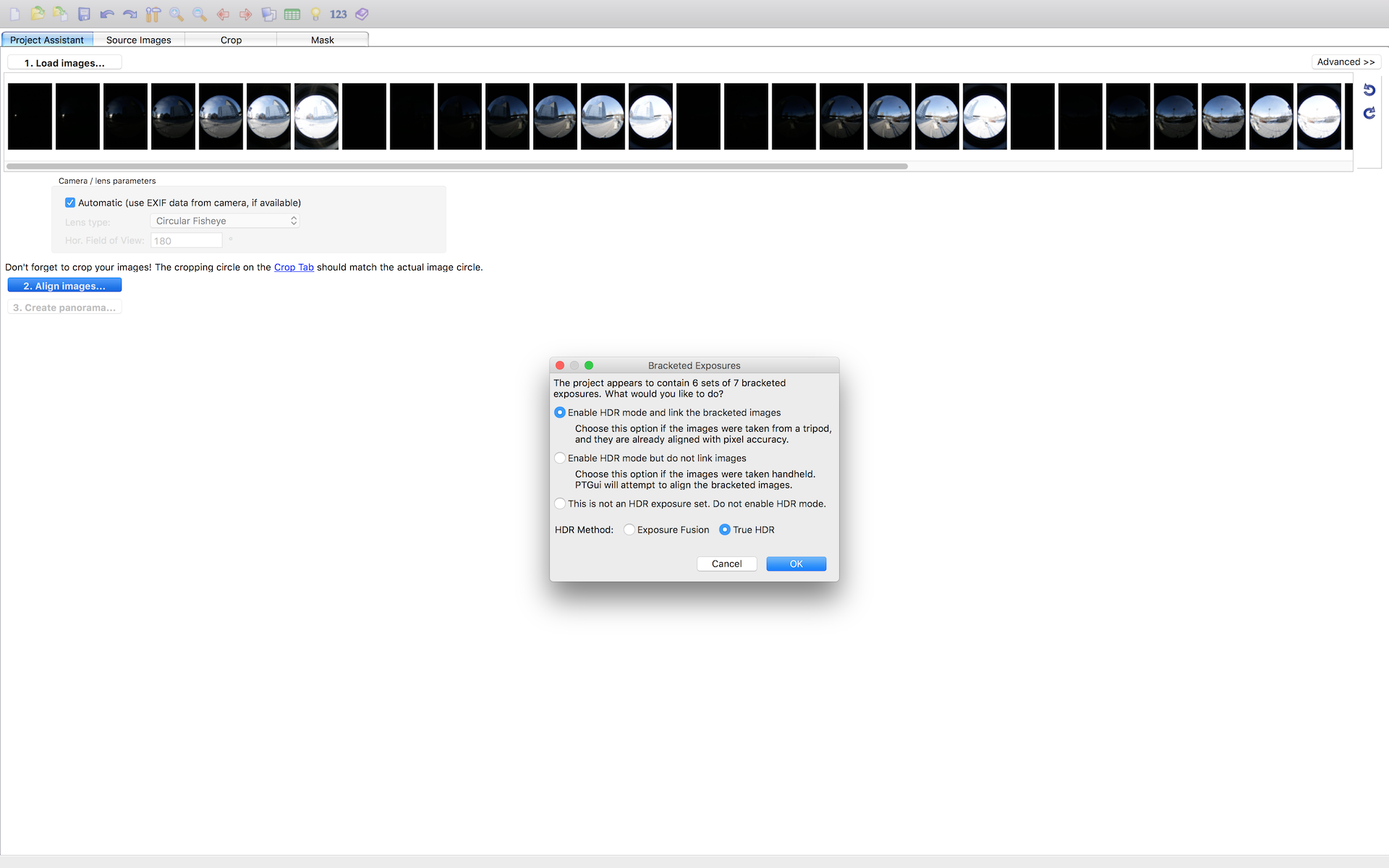

Todos mis brackets están perfectamente alineados, ya que las fotografias se realizaron con un pano head. De esta forma no es necesario perder ni 2 minutos en Ptgui para hacer el stitching.

Las fotografías realizadas con Ricoh Theta, son completamente automáticas, no se pueden controlar de forma manual. Los settings generados son:

- Min exposure: 1/6400

- Max exposure: 1/100

El stitching en este caso, lo hago con Merge HDR Pro en Photoshop, ya que Ptgui no hace stitching de fotografías equirectangulares, (si rectilíneas y fish eye). Nunca deberías utilizar Photoshop para trabajo de datos, así que una vez generado el HDRI guarda como .exr y nunca más la abras en Photoshop.

Me llevo los dos panoramas a Nuke, para neutralizarlos en base a mis referencias. También para limpiar artefactos si fuese necesario, aunque en este caso he pasado olímpicamente de ello.

Si bajamos la exposición en viewport y analizamos el punto de mayor valor lumínico en la imagen, es decir el sol, veremos la brutal diferencia entre un panorama y otro.

- 5D Mark III = 431

- Ricoh Theta: 3.8

Esta información ya debería de ser una valiosa pista del comportamiento de un panorama u otro cuando creemos nuestros setup IBL.

Ya en Maya, creo dos setups de IBL diferentes, uno para cada panorama. Las diferencias son evidentes, especialmente en la densidad de las nombras y la distribución de la luz.

5D Mark III

Ricoh Theta

¿Eres suscriptor de elephant vfx pro? Descárgate el material utilizado en este post y analízadlo tranquilamente en tu casa.

IBL pack 0002

Publicamos de forma gratuita un IBL pack con cinco light-rigs listos para utilizar en tus proyectos VFX. Han sido fotografiados con Ricoh Theta y tienen un rango dinámico de unos 12EV.

Hace un tiempo expliqué como utilizar esta cámara para propósitos de VFX lighting acquisition.

Podéis descargar las imágenes equirectangulares aquí, Los usuarios de elephant vfx pro podéis descargar además, las escenas de Maya/Arnold listas para trabajar. Para ello podéis acceder a vuestra cuenta y descargar el material.

El uso de este material queda restringido a proyectos no comerciales.

Barcelona cafe.

Barcelona cafe render test.

Hobo hotel.

Hobo hotel render test.

Campus i12 green room.

Campus i12 render test.

campus i12 class.

Campus i12 class render test.

Chiswick gardens.

Chiswick gardens render test.

Neutralización de referencias sin gizmos extras

Este post incluye contenido exclusivo para los suscriptores de elephant vfx pro. Un video de 20 minutos explicando el proceso en detalle.

Ya hemos hablado en el blog, y en nuestros cursos, en varias ocasiones acerca de normalización de referencias, neutralización, white balance, etc. No hace mucho, escribí este artículo sobre tech grading en VFX, donde explicaba un poco el proceso más común que siempre tenemos que realizar con cualquier footage que deseemos incorporar en un pipeline de producción de efectos visuales.

Generalmente y siempre en Nuke, podemos utilizar el gizmo mmColorTarget con macbetch charts de referencia fotografiadas en unas condiciones lumínicas conocidas, para realizar el proceso de neutralización. En ocasiones, trabajaremos en producciones donde por las razones que sean, no podamos utilizar el gizmo mencionado, o puede que simplemente trabajames en un software de composición linear diferente, como Fusion o Flame.

También es posible que estemos utilizando referencias de macbeth chart que no son Xrite, las más comunes utilizadas en la industria. Y por lo tanto, el gizmo mmColorTarget no funcione, ya que está construido para trabajar con estas cartas de color. En esta demos estoy utilizando una carta de color Spydercheker 24 de Datacolor.

Aquí explico un método más genérico, con herramientas propias de Nuke, sin necesidad de gizmos externos, para realizar una neutralización de footage decente. En un futuro explicaré este mismo método en Fusion.

Este es el footage que vamos a utilizar para esta demo. En este caso, es una simple referencia, que perfectamente podría ser nuestro plate para look-dev, o una referencia de iluminación para la recreación de un set. Nótese que he buscado condiciones lumínicas extremas, precisamente para poner en evidente manifiesto esta técnicas, para que no haya espacio para sutilezas :)

- Para no complicarnos demasiado, y entender bien el concepto de neutralización, he decidido trabajar de la forma más simple posible en cuanto a espacios de color se refiere. Es decir, vamos a trabajar de forma linear y visualizando el footage a través de una curva sRGB. De este modo, Nuke está configurado en consecuencia.

- En un pipeline de cine, raramente vamos a trabajar así. Seguramente trabajaríamos con una gestión de color más complicada que una simple curva, por ejemplo OCIO o ACES. O en el más simple de los casos, un LUT creado por la producción. Ya hablaré en un futuro de como integrar footage linear y sRGB en un pipeline ACES.

- Debido a las condiciones lumínicas extremas de la imagen, he realizado esta fotografía con un ISO de 1200, consecuentemente tenemos bastante grano en la imagen. Queremos samplear el gris neutro de la carta de color debidamente, así que lo primero que voy a hacer en este caso, es utilizar un denoise.

- En este caso no perdemos calidad y obtenemos un plate limpio. Y en el caso de perder calidad tampoco importaría demasiado, ya que solo queremos samplear valores del swatch gris, el resto de la imagen nos importa poco en este paso.

- Lo primero con lo que tenemos que lidiar de cara a neutralizar un footage, es el white balance. Identificar si las fuentes lumínicas son cálidas o frías. En un entorno controlable, deberíamos de conocer todos los valores de las luces, potencia, temperatura de color, etc. Las macbeth chart están calibradas suponiendo que las fuentes lumínicas son perfectamente blancas y lineares, y en consecuencia, podemos obtener la información rebotada de los swatches.

- En este caso, no conocemos los detalles de las fuentes lumínicas, así que lo que vamos a hacer es simplemente desaturar la imagen. De este modo, obtenemos nada más información de luminancia, olvidándonos del factor temperatura de color.

- Conectando un color lookup a la imagen original, justo después del denoise, y con las 3 curvas seleccionadas, sampleamos el valor del gray swatch en el source.

- En el target, vamos a samplear el mismo gray swatch pero en este caso en la imagen desaturada, ya que esa debe ser la luminancia a utilizar en nuestro plate.

- Ya hemos solucionado el problema de white balance. El siguiente paso es linearizar la imagen. Para ello necesitamos que el grey swatch nos devuelva una respuesta conocida, que en este caso es de más o menos 0.18 que es el valor gris neutro en linear space.

- Podemos utilizar un exposure node y ajustarlo hasta obtener el valor deseado, o simplemente utilizar otro color lookup y ajustar el source y target en consecuencia.

- Y con esto hemos terminado la neutralización de esta imagen. Realizaríamos lo mismo con todo nuestro material (footage, referencias, hdri, etc) para tener el material "conformado" y listo para trabajar en un software de 3D.